고정 헤더 영역

상세 컨텐츠

본문

글: SK브로드밴드 AIX R&D팀 전혜윤 매니저

안녕하세요.

11월의 주요 AI 이슈로 돌아왔습니다!

세레브라스가 AI 추론 속도서 세계 신기록을 세웠습니다.

얼마나 빠른지 궁금하시다구요?

그럼 세레브라스 AI 추론 속도에 관한 내용과 AI 관련 다른 소식들을 세세히 알려드리겠습니다!

<목차>

OpenAI, GPT-4o 업데이트로 최고의 AI 모델 자리를 되찾다

오픈AI 제품 책임자가 밝힌 '챗GPT 잘 쓰는 법' 5가지는

GPT 성능 향상 속도 둔화”… 오픈AI, ‘오라이온’ 개선 위해 전략 수정

👉🏻 위의 목차 중 원하시는 주제명을 클릭하시면, 해당 본문으로 바로 이동할 수 있습니다

OpenAI, GPT-4o 업데이트로 최고의 AI 모델 자리를 되찾다

1. Summary: OpenAI가 최근 여러 새로운 모델을 출시했으나, GPT-4o가 가장 진보된 모델로 업데이트되었다.

최신 업데이트는 창의적인 글쓰기 능력과 파일 읽기/쓰기 기능을 향상시켜 더 자연스러운 텍스트를 생성할 수 있게 했다.

GPT-4o는 Chatbot Arena LLM 리더보드에서 1위를 차지했으며, 특히 창의적인 글쓰기, 코딩, 복잡한 명령어 처리에서 뛰어난 성능을 보였다.

무료 사용자와 ChatGPT Plus 사용자 모두 업데이트된 모델을 사용할 수 있으며, Plus 사용자는 무제한 우선 접근 권한을 가진다.

또한GPT-4o 스냅샷은 이제 API에서 gpt-4o-2024-11-20으로 사용 가능하다.

2. Implication: GPT-4o의 성능 향상은 AI 모델의 텍스트 생성 능력과 파일 처리 능력을 대폭 개선시켜 사용자 경험을 향상시킨다.

특히 ChatGPT Plus 사용자는 이점을 극대화할 수 있어 일상 작업에서 AI 활용도를 높일 수 있다.

3. 참고 기사: https://platform.openai.com/docs/models#gpt-4o

https://www.zdnet.com/article/openai-updates-gpt-4o-reclaiming-its-crown-for-best-ai-model/

오픈AI 제품 책임자가 밝힌 '챗GPT 잘 쓰는 법' 5가지는

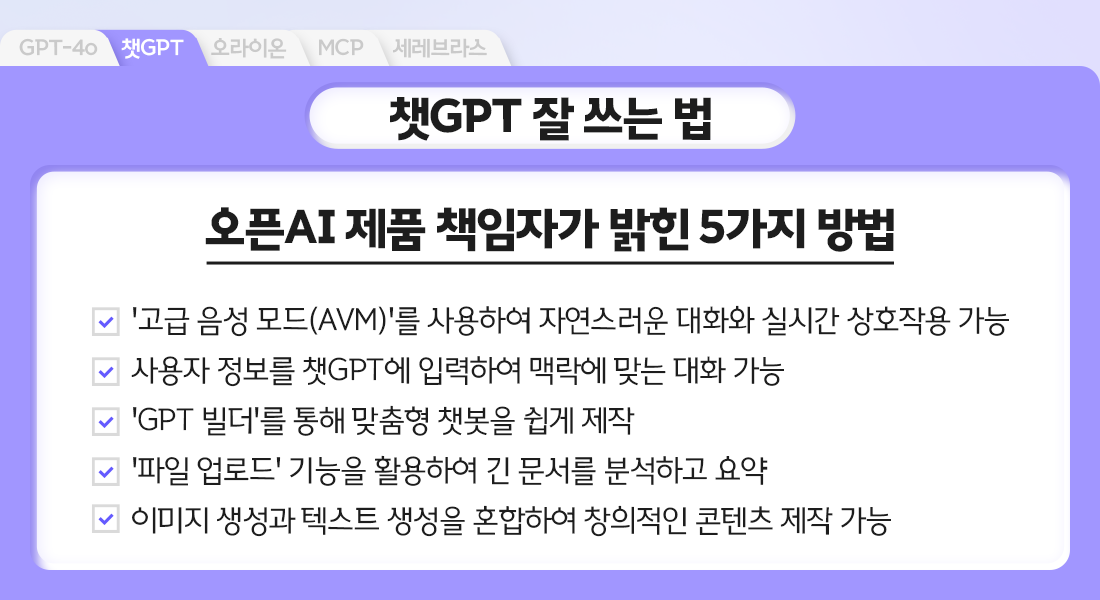

1. Summary: 오픈AI의 제품 책임자 닉 털리가 챗GPT의 생산성을 높이는 5가지 방법을 공유했다.

첫째, '고급 음성 모드(AVM)'를 사용하여 자연스러운 대화와 실시간 상호작용이 가능하다.

둘째, 사용자 정보를 챗GPT에 입력하여 맥락에 맞는 대화를 할 수 있다.

챗GPT는 많은 정보가 입력될수록, 나중 채팅에서 이를 감안한 대화가 가능하며 메모리를 끄거나 심지어 특정 사실을 잊으라고 말할 수도 있다.

셋째, 'GPT 빌더'를 통해 맞춤형 챗봇을 쉽게 제작할 수 있다.

넷째, '파일 업로드' 기능을 활용하여 긴 문서를 분석하고 요약할 수 있다.

마지막으로, 이미지 생성과 텍스트 생성을 혼합하여 창의적인 콘텐츠를 만들 수 있다.

이러한 팁들은 텍스트 전용 챗봇이 멀티모달 모델로 진화하면서 활용 범위가 확대되었음을 보여준다.

2. Implication: 챗GPT의 새로운 기능들은 AI 시스템의 다양한 발전 방향을 제시한다.

음성 인터페이스의 개선은 자연어 처리와 음성 인식 기술의 통합이 중요함을 시사한다.

사용자 정보 활용 기능과 맞춤형 챗봇 제작 도구는 개인화된 AI 서비스 개발의 필요성을 강조한다.

대용량 문서 처리 능력은 정보 추출 및 요약 능력의 고도화를 나타내며, 텍스트와 이미지의 통합은 멀티모달 AI 모델 개발의 중요성을 강조한다

멀티모달 모델 출시가 본격화된 것은 얼마되지 않았고, 이에 따라 유용한 사례가 점차 늘어날 것이라는 전망이다.

3. 참고 기사: https://www.aitimes.com/news/articleView.html?idxno=165514

“GPT 성능 향상 속도 둔화”… 오픈AI, ‘오라이온’ 개선 위해 전략 수정

1. Summary: 오픈AI는 2025년 초 출시 예정인 차세대 AI 모델 '오라이온'의 성능 향상을 위해 노력하고 있으나, GPT-4를 뛰어넘는 성능 달성에 어려움을 겪고 있다.

이에 따라 기존의 사전 훈련 방식 대신 사후 강화 학습과 추론 기능 강화를 중심으로 전략을 변경했다.

이 변화는 '스케일링 법칙'의 한계를 드러낸다.

스케일링 법칙은 더 큰 모델, 더 많은 데이터, 더 높은 컴퓨팅 자원으로 성능이 향상된다는 개념이지만, 최근 성능 개선 속도가 감소하며 한계가 나타났다.

일부는 AI 성장의 한계를 지적하나, 기술 리더들은 여전히 가능성을 주장하고 있다.

오픈AI는 '테스트-타임 컴퓨트'를 도입해 응답 품질을 개선하고, 사전 학습과 추론 능력 강화를 병행하고 있다.

합성 데이터를 활용한 학습도 시도하고 있으나, 새로운 문제 발생 가능성에 대비해 전담 팀을 구성했다.

이러한 노력은 AI 기술이 새로운 국면에 접어들었음을 보여준다.

2. Implication: AI 기술 발전이 스케일링 법칙의 한계에 직면하면서, 기존 모델 확장 중심 전략에서 벗어나 새로운 성능 향상 방안을 모색하는 것이 필수가 되었다.

오픈AI는 사후 강화 학습과 추론 기능 강화를 중심으로 전략을 변경하며, 성능 향상과 투자 비용 간의 균형을 중요한 과제로 삼고 있다.

또한, 고품질 학습 데이터 부족 문제가 새로운 도전 과제로 떠오르고 있어 이를 해결하기 위한 혁신적 접근이 요구된다.

다만 LLM 발전 속도가 둔화되더라도, 에이전트와 같은 응용 분야에서 지속적인 발전 가능성은 여전히 크며, 이와 관련된 서비스는 계속 출시될 것으로 보인다.

3. 참고 기사: https://www.aitimes.com/news/articleView.html?idxno=165134

앤트로픽, AI 시스템을 데이터에 직접 연결하는 도구 출시

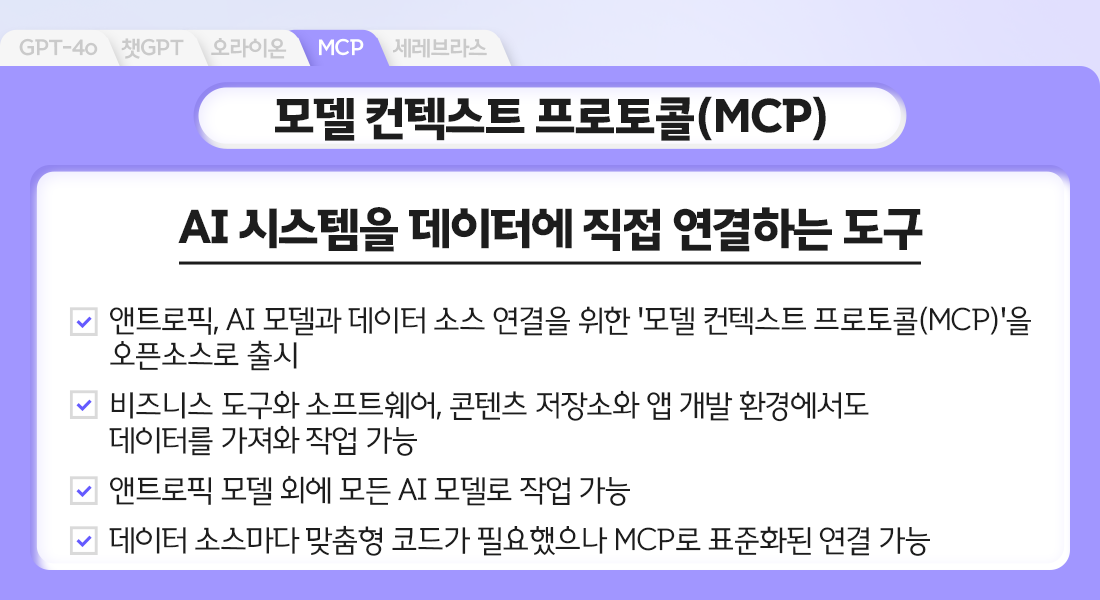

1. Summary: 앤트로픽이 AI 모델과 데이터 소스 연결을 위한 '모델 컨텍스트 프로토콜(MCP)'을 오픈소스로 출시했다.

특히 앤트로픽의 모델에 국한되지 않고, 모든 AI 모델이 비즈니스 도구와 소프트웨어는 물론 콘텐츠 저장소와 애플리케이션 개발 환경에서도 데이터를 가져와 작업을 수행할 수 있게 해준다.

MCP는 개발자가 데이터 소스와 AI 기반 애플리케이션 간의 양방향 연결을 구축할 수 있도록 돕는 프로토콜을 제공한다.

개발자는 ‘MCP 서버’를 사용해 데이터를 노출하고, 명령에 따라 해당 서버와 연결되는 애플리케이션이나 워크플로우 같은 ‘MCP 클라이언트’를 만들 수 있다.

기존에는 데이터 소스마다 맞춤형 코드가 필요했으나 MCP로 표준화된 연결이 가능하다.

그러나 오픈AI와 같은 경쟁자를 제치고 널리 채택될지는 미지수다.

경쟁사는 기업 파트너들이 자사의 데이터 연결 방식을 사용하도록 유도할 것이 뻔하기 때문이다.

실제로 오픈AI는 최근 '타사 앱 통합(Work with Apps)'이라는 데이터 연결 기능을 챗GPT에 추가해, 개발자용 코딩 앱에서 코드를 읽을 수 있게 했다.

2. Implication: AI 생태계에서 데이터 연결 표준화가 중요한 경쟁 포인트로 부상하고 있다.

데이터 연결 표준화 영역에서도 오픈소스 전략과 폐쇄형 전략의 대립이 주요 이슈가 될 것으로 전망된다.

개발자들의 생산성 향상과 효율적인 AI 시스템 구축을 위해 표준화된 프로토콜의 필요성이 증가하고 있다.

SKB에서도 LLM에 활용하던 다양한 프레임워크에 대한 효율성을 재고하고, 위와 같은 데이터 연결 전략들을 테스트해 볼 필요가 있어 보인다.

3. 참고 기사: https://www.aitimes.com/news/articleView.html?idxno=165663

세레브라스, AI 추론 속도서 세계 신기록 수립..."GPU보다 75배 빨라"

1. Summary: 세레브라스가 자체 개발한 WSE 프로세서로 메타의 LLM '라마 3.1 405B'를 초당 969 토큰 속도로 실행하며, 세계 최고 속도의 AI 추론 성능을 기록했다.

이는 AWS의 GPU 기반 AI 서비스보다 75배 빠른 성능이다.

클라우드 기반 AI 추론 서비스인 '세레브라스 인퍼런스(Cerebras Inference)'는 엔비디아나 AMD GPU를 사용하는 대신, 자체 개발한 3세대 '웨이퍼 스케일 엔진(WSE)' 프로세서를 활용한다.

라마 3.1 405B는 메타가 출시한 4050억개의 매개변수를 가진 기존 '라마 3.1 70B'보다 훨씬 복잡한 모델이다.

세레브라스는 WSE 프로세서가 초당 969토큰 처리 속도와 첫 토큰 생성 시간 0.24초를 기록하며 모델을 실행했다고 밝혔다.

또한 쿼리 크기를 10만토큰으로 확장해도 초당 539토큰 속도를 유지했다.

세레브라스에서 실행되는 라마 3.1 405B는 'GPT-4o'보다 12배, '클로드 3.5 소네트'보다 18배 빠른 성능을 보여주며 세계에서 가장 빠른 프론티어 모델로 자리 잡았다.

2. Implication: AI 추론 성능의 핵심은 하드웨어 기술력에 있으며, 자체 개발한 프로세서가 기존 GPU보다 우수한 성능을 낼 수 있음을 입증한 사례가 등장했다.

세레브라스의 기술력이 엔비디아의 GPU 독점 체제를 흔들 수 있는 대안으로 부상했을 뿐 아니라, 앞으로 더 많은 기업이 이 경쟁에 참여할 것으로 예상된다.

또한, 대형 언어 모델의 처리 속도가 획기적으로 개선되면서 실시간 AI 서비스 구현이 더욱 현실화되었다.

AI 추론 시장에서 속도 경쟁이 본격화되면서 기업들의 기술 혁신이 가속화될 것으로 전망된다.

3. 참고 기사: https://www.aitimes.com/news/articleView.html?idxno=165559

오늘 준비한 11월 AI 이슈들, 어떠셨나요?

테스트-타임 컴퓨트 도입으로 합성 데이터를 활용한 학습도 시도하고 있는데요.

이러한 노력으로 인해 AI 기술은 어떤 국면을 맞이하게 될 지 궁금해지네요.

그럼 이만 마무리하며, 다음에도 더 흥미로운 AI 관련 소식들을 발빠르게 가져오겠습니다.

'NEWS > AI 트렌드' 카테고리의 다른 글

| [12월의 AI 트렌드] AI가 3D 가상 세계도 만든다고?! (0) | 2025.01.14 |

|---|---|

| [12월의 AI 트렌드] AGI 시대가 5년밖에 남지 않았다?! (0) | 2025.01.14 |

| [11월의 AI 트렌드] AI의 취약점까지 알려주는 스캐너 도구가 등장했다?! (1) | 2024.12.09 |

| [10월의 AI 트렌드] 대형언어모델이 논리적 추론을 하지 않는다고?! (1) | 2024.11.13 |

| [10월의 AI 트렌드] GPT-4보다 12배 빠른 AI가 등장했다, 아치-함수 시리즈! (2) | 2024.11.13 |

댓글 영역